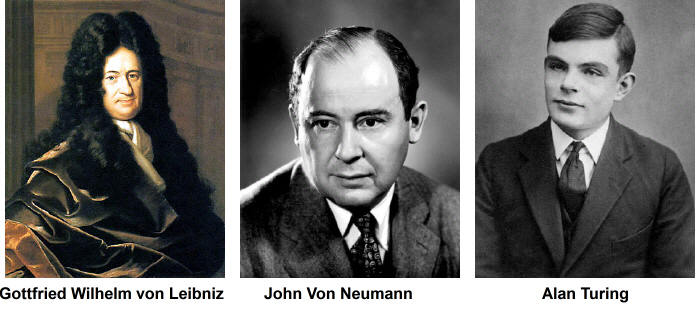

Au XVIIème siècle, alors que Blaise Pascal venait de créer la première machine à calculer, Gottfried Wilhelm von Leibniz rêve d'un "calculus ratiocinator", une super calculatrice qui, grâce à une langue hypothétique, permettrait d'exprimer la totalité de la pensée humaine.

Pour que cela commence à être possible, il faudra attendre 1945 et John Von Neumann qui définira l'architecture des ordinateurs en s'inspirant du fonctionnement du cerveau humain où les informations et leur traitement existent dans une même structure de "stockage", les neurones.

En 1950, Alan Turing se demande si une machine peut sembler "penser" et propose un test : faire dialoguer à distance une machine et un humain sans que ce dernier ne puisse déterminer si son interlocuteur est un humain ou une machine pendant un temps conséquent.

Il semblait alors que cela ne deviendrait possible que quand les ordinateurs auraient autant d'unités de mémoire que le nombre de neurones d'un cerveau humain, soit près d'une centaine de milliards ! À l'époque, les ordinateurs en comptaient quelques milliers tout au plus.

Qu'à cela ne tienne, le premier à utiliser le terme "intelligence artificielle" sera John McCarthy en 1956 dans sa conférence "Dartmouth Summer Research Project on Artificial Intelligence". Et c'est le vrai début de l'aventure.

Les premiers résultats seront obtenus par les "systèmes experts", ils seront plutôt décevants. En gros, un système expert simule le savoir-faire d'un spécialiste en analysant le problème posé et en répondant en ayant accès à la base de connaissance de la spécialité. Cela reste relativement proche de la programmation classique basée sur des algorithmes et ressemble finalement à un jeu de questions-réponses préétablies.

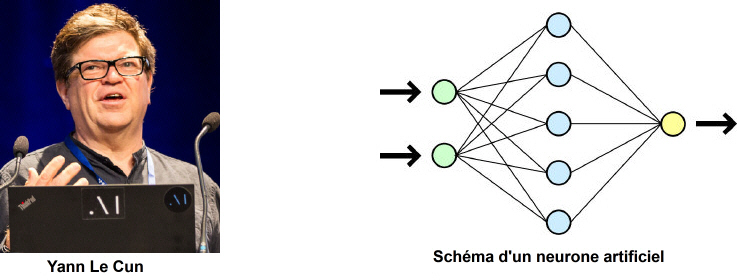

Parallèlement, se développent d'autres solutions à base de "réseaux de neurones artificiels" imaginées dans les années 1950. Elles semblent très prometteuses, mais, faute de disposer de la puissance de calcul nécessaire et de suffisamment de données, elles vont mettre beaucoup de temps à s'imposer.

Grâce notamment aux idées de Yann Le Cun, elles feront d'énormes progrès dans les années 2010, quand il deviendra courant d'avoir des ordinateurs possédant une grande puissance de calcul, des dizaines de milliards d'unités de capacité de stockage et quand ces mêmes ordinateurs auront facilement accès à la gigantesque base de donnée que constitue le Web.